事案通報システム

We have renamed the Private Incident Reporting System as Incident Reporting System. The word "Private" has been removed. In the context of harassment and the UCoC the word “Private” refers to respecting community members’ privacy and ensuring their safety. It does not mean that all phases of reporting will be confidential. We have received feedback that this term is therefore confusing and can be difficult to translate in other languages, hence, the change. |

概要

ウィキメディア財団では嫌がらせ行為やその他の形態の害をこうむった当事者が、そのような有害な事案を通報する方法を改善したいと考えており、コミュニティにもっと安全で健全な環境をもたらそうとしています。

そこで信頼と安全製品チーム(Trust and Safety Product team)の任務として、事案通報システム(IRS=Incident Reporting System)を設けます。有害な事案を利用者が安心してまた非公開で、より簡便に通報する方法を目指します。(旧称は非公開事案通報システム=PIRS※) (formerly (※=Private Incident Reporting System)。

プロジェクトの背景

有害な事象を報告し処理することは、長年ウィキメディアコミュニティーにとって関心のある話題でした。新たに設定されたUniversal Code of Conductと共にユーザー報告制度について話すことも重大なことです。

暴力事件や違法行為、ポリシー侵害がウィキメディア空間やプロジェクトを通じて合意された方法は、組織的に発展してきており、コミュニティー毎に異なります。

ウィキメディアプロジェクトやコミュニティー毎に運営方法は違います。暴力事件の報告や処理は、様々な方法で行われます。

- ウィキのトークページを使う

- 掲示板を使う

- メールを使う

- オフウィキの話し合いのチャネルで非公開の協議(Discord、IRCのチャット)

事案が発生しても、どうしたら良いかわからない利用者は大勢います。相談する場所も、誰に言えば良いか、どう通報するのか、通報にはどんな情報が必要か、通報するとどう処理されるのか、その後はどうなるのか等々、不明なことだらけです。

ユーザーは問題を報告する方法と場所を知らなければなりません。報告が行われると起こることとユーザーが持つべき予測に関する情報も殆どありません。

一部のユーザーは、報告手続きが複雑でプライバシー保護を憂慮するために事件が起きた時に安全に事件を報告できないと感じています。

現在ユーザーが個人的に報告を提出する方法は規格化されていません。

プロジェクトの対象

従ってこのプロジェクトの高度な目的は、ハラスメントや有害な事象に対処しやすくすること、それらレポートの処理を担う適切な実態に確実に届けることにあります。

報告する人のプライバシーと安全を保証したいです。処理する人に余計な圧力を掛けない一方で、報告が正しい情報であることも保証し、処理を担う適切な実態への道のりに乗せたいのです。

信頼安全製品班もこの事象報告制度を、コミュニティ関連のより大きな事案管理体制の一環として見ています。私たちは個々のシステムの機能と、すべてがどのように連携するか研究しています。

成果と技術アップデート

事案通報システムのベータ環境におけるMTPをテスト – 2023年11月10日

編集者の皆さん、開発初期段階の 事案通報システムの仮説検証可能な最小限の製品(MTP=Minimum Testable Product)のテストにご参加ください。

信頼安全製品チームでは事案の発生に備えて、各利用者がトークページから通報できるよう、基本的な製品版を作成しました。

注期:この版の製品は、非公開のメールアドレス宛に送る通報について、知見を得るためにあります。(例えばemergency![]() wikimedia.org または管理者グループ。)シナリオとして想定できるすべての場合に対応できるわけではなく、公開の伝言板への対応はできません。

wikimedia.org または管理者グループ。)シナリオとして想定できるすべての場合に対応できるわけではなく、公開の伝言板への対応はできません。

この初期段階が効果的かどうか判断に使いますので、ぜひ皆さんのフィードバックをお寄せください。

テストをしてみる:

1. ベータ版のウィキペディアで好きなトーク名前空間のページを開き、そこに協議があることを確かめます。サンプルのトークページは User talk:Testing と Talk:African Wild Dog ですので、ログインしてどちらかを使うことも可能です。

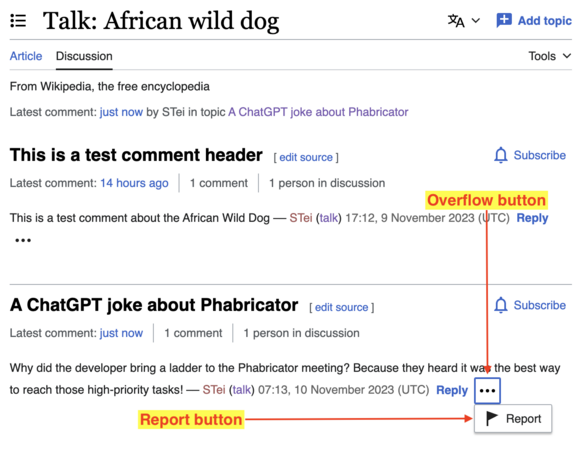

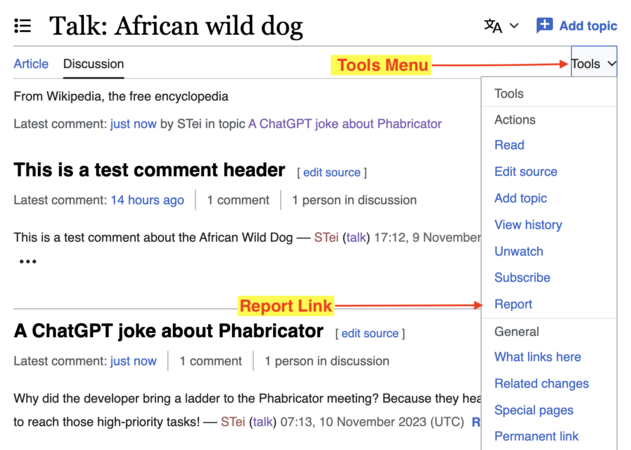

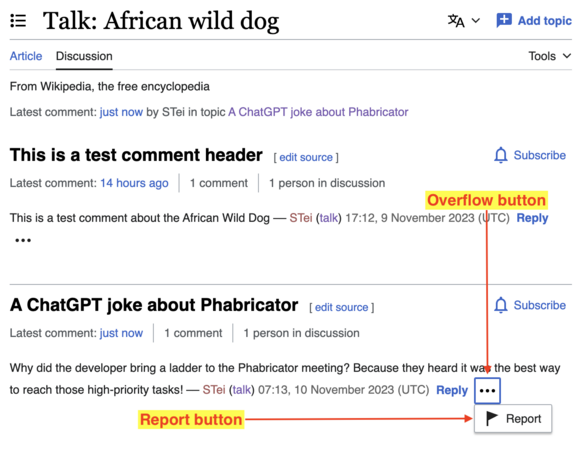

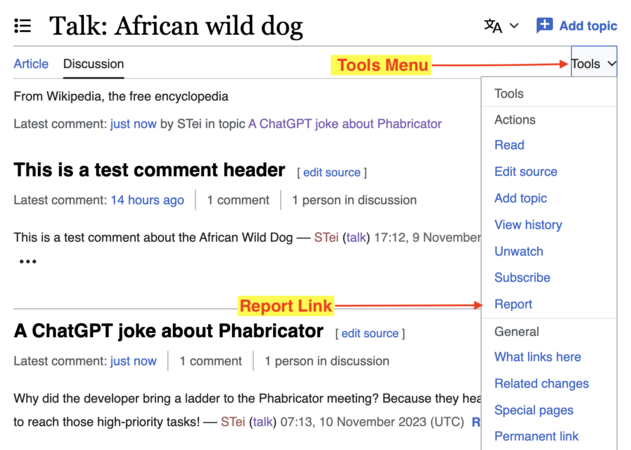

2. 次に画面上のコメント窓の Reply リンクのそばにオーバーフロー・ボタン(縦に折りたたみ式)があります。それを押してメニューを展開、Report をクリック(スライド1ご参照)。あるいは Tools メニューの Report リンクを押します(スライド2)。

-

スライド1

スライド1 -

スライド2

スライド2

3. 次に通報の手順に進み、フォームに記入して送信します。するとメールが信頼安全製品チームに届き、このアドレスでしか皆さんの通報は読めません。今回はあくまでもテストであり、現実に発生した事案の通報には使えません。

4. テスト中は、次の質問を頭に置いて操作してください。

- この通報システムの感想は? 特に、どこがよいか、嫌いな点はどこですか?

- 拡張機能というものに慣れている人なら、これを皆さんがいつも活動するウィキに導入したいですか?

- この諸機能通報段階で、何か見落とした課題はありませんか?

5. テストが完了したら、トークページにご指摘やご意見、ご質問を投稿してください。

== トラブル対策 ==

オーバーフローメニューが見つからない、通報リンクがない、記入したのにフォームを送信できない場合は、次の点を確認してください。

議論ツールを読み込めない場合、ツールメニューからバグを報告してください。("※"=DiscussionTools。) 2回目の通報ができない場なら、未承認の利用者の場合、同じ事案なら1日の通報は1回限定、自動承認利用者の上限は1日5回とされていますのでご注意ください。テスト実施前、これらの要件は悪意のある利用者にシステムを濫用されないようにする役に立ちます。 |

情報更新:事案通報の調査結果とわかったことを公開 – 2023年9月20日

事案通報システム・プロジェクトは、試案版ウィキにおいて嫌がらせ行為に関する調査を完了したところです。

2023年初頭に始めたこの調査はウィキペディアのインドネシア語版と朝鮮語版を対象に、嫌がらせ行為の内容の把握と、通報の方法、通報を受けた人の対処手順はどのように進むか理解するためです。

調査結果を公表しました。

Please see the research section of the page for more.

Four Updates on the Incident Reporting Project – July 27, 2023

Hello everyone! For the past couple of months the Trust and Safety Product team has been working on finalising Phase 1 of the Incident Reporting System project.

The purpose of this phase was to define possible product direction and scope of the project with your feedback. We now have a better understanding of what to do next. Read more.

2022年11月8日:プロジェクトの範囲とMVP

過去2か月間の主な目的は、このプロジェクトを巡る問題点とユーザーの期待を理解することにありました。取り組みたい方法は、見ている基本的な経験が実際に動くか助けとなる小さなもの(実用最小限の製品(MVP))を構築することにあります。詳細はこちら。

手順

これは複合的なプロジェクトですので、複合的な反復作業とプロジェクトの段階に分ける必要があります。大きな仕事量にならない内にこの段階ごとに正しい道筋を歩み早期にコミュニティーフィードバックを合体させることを保証するために1回から数回の討議を行います。

第1段階

予備調査:実際の文書を読みながらフィードバックを集める。

問題をよく理解し回答が必要な決定的な質問を確認するためにインタビューを行う。

向かうべき可能な成果とプロジェクトの範囲を明らかにし討議する。可能なパイロットウィキを明確にする。

この段階の終わりにしてみたいことを堅実に理解すべきです。

第2段階

第1段階で明らかになった考え方を説明する原型を作ります。

更に深い協議と再調査のための可能な選択肢のリストを作ります。

第3段階

最高の可能性のある考え方を明確に優先順位をつける。

ソフトウェア開発に移行し作業をファブリケーター綱領に細分化する。

次の反復作業のために循環を続ける。

調査

15 July 2024 Update: Sharing Incident Reporting System Minimum Viable Product (MVP) User Testing Summary

In March 2024, the Trust & Safety Product team conducted user testing of the Minimum Viable Product (MVP) of the Incident Reporting System to learn if users know where to go to report an emergency incident, and if the user flow makes sense and feels intuitive.

We learned the following:

- During user testing, all participants found the entry point to report an incident and the current user flow is well understood.

- There was some confusion over two of the reporting options: “someone might cause self-harm” and “public harm threatening message”.

Two participants also made assumptions about the system being automated. One participant was concerned about automation and wanted a human response, whereas the other participant felt assured by the idea it would check if the abuser had any past history of threats and offences, and delete the offensive comment accordingly. All participants expected a timely response (an average of 2-3 days) after submitting a report. Read more.

21 September 2023 Update: Sharing incident reporting research findings

The Incident Reporting System project has completed research about harassment on selected pilot wikis.

The research, which started in early 2023, studied the Indonesian and Korean Wikipedias to understand harassment, how harassment is reported and how responders to reports go about their work.

The findings of the studies have been published.

In summary, we received valuable insights on the improvements needed for both onwiki and offwiki incident reporting. We also learned more about the communities' needs, which can be used as valuable input for the Incident Reporting tool.

We are keen to share these findings with you; the report has more comprehensive information.

Please leave any feedback and questions on the talkpage.

事前の作業

信頼安全製品担当チーム(Trust and Safety Product team)では作業を案内する事前の調査とコミュニティー協議を研究しています。コミュニティ健全性イニシアチブの利用者通報システムの素案ならびに、2019年利用者通報システムの聞き取り調査を再考しました。さらにまた、コミュニティでは現状、衝突解消にどのように取り組んでいるのか理解しようと、さまざまなウィキが採用している衝突解消の手順からいくつかを取り出し、比較してきました。下記にイタリア語版ウィキペディアの衝突解消の段取りを示してあります。自動化できそうな箇所には、注釈をつけました。

FAQ

答:現時点で使える明確なデータはそれほどありません。これには二つ理由があります。第一に問題は様々な方法で報告されコミュニティーごとに異なっています。このデータを完全で明確に把握するのは、非常に困難で、非常に時間を消費するものになります。第二に問題の解釈も異なっています。ハラスメントと解釈されることがウィキの仕事に過ぎないことがあります(例:プロモーション項目の削除)。ハラスメントの再検証は文化的な背景やコミュニティーの背景も必要です。データをオートメーション化し視覚化したり客観的に数えることはできません。事象報告制度はこのデータ需要の一部を解決する機会です。

問:ハラスメントと定義されるのはどのようなものですか。

答:ユニバーサル行動規範の定義をご覧ください。

問:IRS対応の担当には、職員やボランティアがなん人くらい必要になりますか。

答:現在この問題の重要性は不明です。(実用最小限の製品を経験することは、IRS対応に必要な人数の見込みをもたらしてくれます。

問:MVP(実用最小限の製品)の目的は何ですか。

答:MVPは学習するための実験と機会です。この最初の実験は今現在持っている疑問に答えてくれます。この結果は将来の計画を導くでしょう。

問:実用最小限の製品と共にどんな疑問に答えようとしていますか。

答:ここに答が必要な疑問があります。

- どんな種類の報告を提出しますか。

- どのくらいの人が報告を提出しますか。

- 処理するために何人の人が必要になりますか。

- この問題の大きさはどれ位ですか。

- ハラスメント問題の重大性の明白な状況が分かりますか。報告の数を巡るデータを得られますか。ハラスメントは過少申告されていますか、過大申告されていますか。

- 起こっていないかどのようなものか知らないために現在人々はハラスメント報告していないのですか。

- これは現在の組織で処理できる状況ですか、違いますか。

- ウィキプロセスを理解していない人と比べて妥当な苦情はどれ位ありますか。妥当な苦情を識別したりフィルターにかけ、ボランティアや職員が時間を節約できるように不当な報告を排除できますか。

- 編集が差し戻されたりページが削除されたことに憤慨する人から提出される多くの報告を受け取りますか。することは何ですか。

問:ウィキメディア運動はフェイスブックやRedditのような大きなプラットフォームがハラスメントを処理する方法とどのように比較していますか。

答:同じオンライングループがないとはいえ、ウィキメディア運動はハラスメントを処理する方法に関してフェイスブックやRedditとしばしば関係を持っています。考える上で重要なことは、誰もハラスメントを解決していないということです。他のプラットフォームは、節度あるコンテンツに取り組み、しばしば取り組む有給の職員がいます。Redditやフェイスブックとの二つの大きな違いは、ウィキメディアのプロジェクトが国際的に協同する性質であり、コミュニティーがコミュニティー内部のハラスメントをどのように解決しようと機能するかという点です。

問:ウィキメディア財団は現存するコミュニティープロセスを改定しようとしていますか。

答:IRS用の計画は、コミュニティープロセスを改定するものではありません。目的は現存するプロセスに繋がることです。最終目的は以下の通りです。

- ハラスメントを受けた人が容易に助けを得られるようにする。

- ハラスメントを報告する方法を知らないために報告しない状況を除去する。

- ハラスメントの報告が地域コミュニティープロセス毎に処理する然るべき部署に届くことを保証する。

- 応答者が良い報告を受け他で処理すべき事実無根の苦情や問題を転送することを保証する。